摘要

在各种复杂环境中运行的强化学习智能体可以从其行为的结构分解中受益。通常,这是在分层强化学习的语境下解决的,往往目标是将策略分解为较低级别的原语或选项,同时较高级别的元策略针对给定情况触发适当的行为。但是,元策略仍必须在所有状态中做出适当的决定。在这项工作中,我们提出了一种策略设计,该策略设计可分解为原语,类似于分层强化学习,但没有高级元策略。相反,每个原语可以自己决定是否希望在当前状态下执行操作。我们使用信息论机制来实现此分散决策:每个原语都会选择需要多少有关当前状态的信息以做出决定,请求有关当前状态最多信息的原语被选择与环境交互。对原语进行正则化以使用尽可能少的信息,从而导致自然竞争和特异化。我们通过实验证明,该策略体系结构在泛化方面比平面策略和分层策略都有所改进。

论文信息

- 作者:Goyal, A., Sodhani, S., Binas, J., Peng, X. Bin, Levine, S., & Bengio, Y.

- 出处:ICLR2020 Poster

- 机构:Facebook, UCB

- 关键词:原语生成,信息论,去中心化原语决策

- 论文链接

- 其他资料:

内容简记

方法

尽管分层强化学习通过分解可以使得底层原语可以特异化面对不同状态,并能够被元策略加以组合或选择。然而元策略本身仍然需要处理所有状态空间,从而使得元策略在不同环境中的迁移成为瓶颈。

该方法包括三个组件:

- 一种将特定原语限制在状态空间子集的机制

- 原语之间的竞争机制,从而为给定状态选择最有效的原语

- 规范化机制,可提高策略整体的泛化性能。

包含信息瓶颈的原语

这里作者对每个原语设计一个信息瓶颈,以防止其利用状态中的全部信息(这里我认为是在迫使原语提取主要信息,以增强泛化性)

通过Z(隐变量状态空间)的分布与正态分布之间的KL散度作为罚项以期另Z中包含尽可能少的关于S的信息,文中的表述是原语需要通过对$L_k$支付“信息损失”已获得关于当前状态的更多信息。

这里的正态分布可被替换为预先学习的先验。

尽管信息瓶颈使得原语能获得的关于状态的信息尽可能少,然而并没有约束不同原语去关注状态空间中的不同部分,所以进一步提出了竞争机制以鼓励原语的多样性。

信息约束的竞争原语

由于原语面对状态s时的$L_k$体现了其对于当前状态的有效性,所以最高$L_k$的原语应当被激活。这里采用softmax计算归一化权重的方法

选择$\alpha_{k}$最高的或通过构造分布然后采样的方式,决定要激活的原语。

通过$r_{k}=\alpha_{k} r,$ 其中 $r=\sum_{k} r_{k}$的方式鼓励每个原语从状态中获取更多信息,与信息瓶颈相拮抗,使得每个原语特异化。

组合表示的正则化

采用如下的额外正则化项,鼓励多样化的原语设置,以及保证模型不会坍缩到单一原语

可以重写为

前项使得$\alpha$熵值增加,进而使得原语选择集合具有多样性。LSE则近似于参数的最大项,$\operatorname{LSE}(x) \approx \max _{j} x_{j}$,因此惩罚了占主导地位的$L_k$项,使他们趋向一致

目标与算法总结

总目标函数包含3项:

- 来自标准RL目标的期望奖励,$R(\pi)$,根据参与度将其分配给不同原语

- 单个瓶颈项导致单个原语专注于状态空间的特定部分,$L_k$,其中$k = 1,\dots,K$

- 归一化项应用于组合模型,$L_{reg}$

对于第k个原语的总目标函数如下:

实验结果

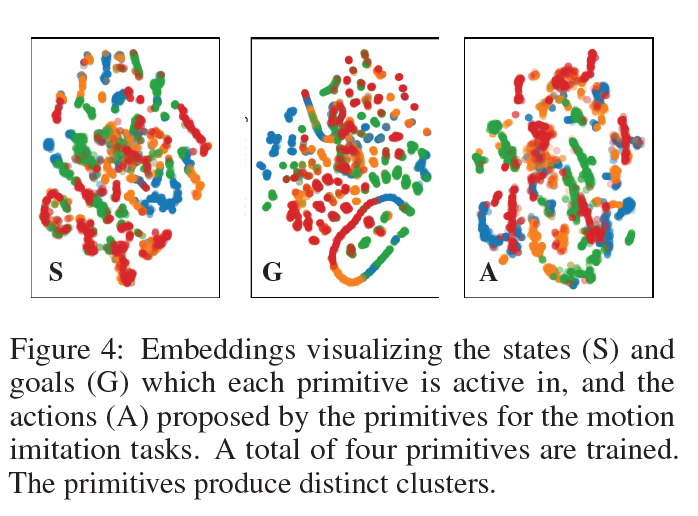

如图,每个面板对应于不同的训练设置,其中不同的任务表示为A,B,C,…,具有n个圆圈的矩形对应于由在相应任务上训练的n个原语组成的代理。 第一行:为受过单个任务训练的代理原语的激活。 下面一行:重新训练:在A上训练了两个原语并迁移到B。结果(成功率)表明,多原语模型比baseline(transfer A2C)实质上具有更高的样本效率。 复制和合并:随着时间的推移,更多的原语以即插即用的方式添加到模型中(在A上训练了2个原语;模型通过自己的副本扩展自身;在B上训练了所得的四原语模型。)对比比其他强baseline更有效。零样本泛化:在C上训练一组原语,并评估对A和B的零样本泛化。这些原语学习一种空间分解的形式,这使它们可以在目标任务A和B中处于活动状态。